فایل Robots.txt در وبسایتها نقش راهنما را دارد در این مقاله با ما همراه باشید تا با کاربرد آن آشنا شوید.

Robots.txt یک فایل متنی است که صاحبان وب سایت ها برای این که به ربات های وب (در واقع بیشتر همان ربات های موتورهای جستجو) نحوه Crawl کردن صفحات سایت خود را یاد بدهند، ایجاد می کنند. این فایل بخشی از پروتکل خارج کردن ربات ها (REP) است، یعنی گروهی از استانداردها که تعیین می کنند ربات ها چگونه فضای وب را Crawl کنند، به محتواها دسترسی داشته و آن ها را ایندکس کنند و آن محتوا را به مخاطبان نشان دهند. REP همچنین شامل بخش نامه هایی مانند Meta robotها، به همراه Subdirectoryهای صفحات یا دستورالعمل های گسترده سایت به منظور نشان دادن نحوه رفتار موتورهای جستجو با لینک ها (مانند لینک های follow و nofollow) می شود.

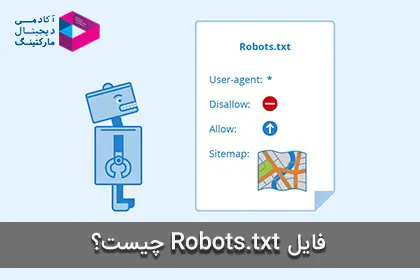

در عمل، فایل های Robots.txt نشان می دهند که آیا ماموران کاربری مشخص (نرم افزارهای Crawl کننده وب) می توانند یا نمی توانند بخش های از وب سایت را Crawl کنند. این دستورالعمل های بررسی سایت به صورت اجازه دادن یا ندادن به انجام یک رفتار مشخص از سوی یک مامور کاربری اختصاص می یابند. فرمت پایه این فایل را در این قسمت مشاهده کنید.

به همراه هم، این دو خط به عنوان یک فایل Robots.txt کامل محسوب می شوند. اگرچه که یکی از فایل های ربات ها می تواند شامل چندین خط از ماموران کاربری و بخشنامه ها باشد. درون یک فایل Robots.txt، هر دسته از بخشنامه های User Agentها به عنوان یک دسته جداگانه ظاهر می شود که توسط یک فاصله میان خطوط از هم جدا می شوند.

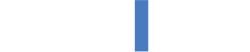

در یک فایل Robots.txt با چندین بخشنامه کاربری، هر قانون صلاحیت دادن یا ندادن تنها به همان کاربران مشخص شده در آن دسته بخشنامه های جدا شده از دیگران اختصاص داده می شوند. اگر یک فایل شامل قانونی باشد که روی بیش از یک کاربر اعمال می شود، یک Crawler تنها به مشخص ترین گروه دستورالعمل ها توجه خواهد کرد. به مثال زیر توجه کنید.

Msnbot، discobot و Slurp همگی به وضوح فراخوانده شده اند، بنابراین آن ربات ها تنها به بخش نامه های موجود در قسمت آن ها درون فایل Robots.txt توجه خواهند کرد. دیگر User Agentها بخشنامه های قرار داده شده در گروه User Agent* ها را دنبال خواهند کرد. اگر تا به اینجا همچنان خیلی متوجه مفهوم این فایل ها و اهمیت آن ها نشده اید، بیایید کمی ساده تر به موضوع نگاه کنیم.

اهمیت فایل Robots.txt چیست؟

اول از همه باید دید که چرا فایل های Robots.txt برای ما اهمیت دارند؟ همان طور که گفته شد این فایل ها یک فایل متنی هستند که به ربات های وب می گویند که کدام صفحات سایت شما را بررسی یا Crawl کنند، اما این فایل ها همچنین به ربات مذکور می گویند که کدام صفحات را نادیده بگیرد.

فرض کنید که یک موتور جستجو می خواهد از سایتی بازدید کند. قبل از این که از سایت هدف بازدید صورت بگیرد، فایل Robots.txt را به منظور گرفتن دستورالعمل ها چک می کند. مشخصاً انواع مختلفی از این فایل ها وجود دارد، بنابراین بیایید نگاهی به چند مثال از اشکال مختلف آن ها داشته باشیم.

فرض کنید که یک موتور جستجو این مثال از فایل Robots.txt را پیدا می کند:

User Agent: *

Disallow: /

این اسکلت پایه یک فایل Robots.txt است. ستاره بعد از User Agent بدین معنیست که فایل Robots.txt بر روی تمامی ربات های وبی که از سایت بازدید می کنند اعمال می شود. همچنین علامت اسلش بعد از Disallow نیز به ربات می گوید که کدام صفحات سایت را بازدید نکند. شاید برای شما سوال پیش آمده باشد که چرا یک شخص نباید بخواهد که بعضی از صفحات سایتش بازدید شوند؟ چرا که یکی از بزرگترین اهداف سئو این است که کاری کنید که موتورهای جستجو سایت شما را به راحتی بررسی کنند تا بتوانند رتبه شما را افزایش دهند. اینجا جایی است که ترفند سئوی این بخش ظاهر می شود.

شما احتمالاً صفحات زیادی روی سایت خود دارید، درست است؟ حتی اگر فکر می کنید که این طور نیست، چک کنید، به احتمال زیاد شگفت زده خواهید شد. اگر یک موتور جستجو سایت شما را بررسی کند، تمامی صفحات شما را بررسی خواهد کرد و اگر صفحات زیادی داشته باشید، مدتی طول می کشد تا ربات موتور جستجو سایت شما را بررسی کند که می تواند تاثیر منفی روی رتبه شما داشته باشد. دلیل این اتفاق چیست؟ چون ربات گوگل یک بودجه “بررسی (Crawl Budget)” دارد. این بودجه به دو بخش تقسیم می شود که بخش اول محدودیت Crawl است. بیایید تعریف گوگل از این بخش را ببینیم.

محدودیت Crawl

ربات گوگل به گونه ای طراحی شده است که یک شهروند خوب در فضای وب باشد. بررسی کردن اولویت اصلی آن است، در حالی که اطمینان حاصل می کند که این کار باعث افت تجربه کاربری کاربرانی که از سایت بازدید می کنند نمی شود. ما به این موضوع محدودیت نرخ بررسی می گوییم که حداکثر نرخ بررسی یک سایت مورد نظر را محدود می کند.

به زبان ساده، این نرخ نشان دهنده تعداد ارتباطات همزمان موازی است که ربات گوگل ممکن است برای بررسی سایت استفاده کند به همراه زمانی که باید بین بررسی ها صبر کند. نرخ بررسی می تواند بر اساس دو فاکتور بالا و پایین برود:

- سلامت Crawl: اگر سایت برای مدتی خیلی سریع پاسخ بدهد، محدودیت بالاتر می رود، بدین معنی که از ارتباطات بیشتری می توان برای بررسی استفاده کرد. اگر سایت کُند شود یا با ارورهای مربوط به سرور پاسخ دهد، محدودیت پایین می آید که ربات گوگل کمتر به بررسی می پردازد.

- محدودیت تعیین شده در سرچ کنسول: صاحبان سایت ها می توانند بررسی ربات های گوگل را در سایت خود کاهش دهند. در نظر داشته باشید که بالا بردن محدودیت ها به صورت اتوماتیک بررسی را افزایش نمی دهد.

بخش دوم تقاضای بررسی است.

تقاضای Crawl

حتی اگر ربات به محدودیت Crawl نرسیده باشد، اگر تقاضایی برای ایندکس کردن نباشد، فعالیت رابت گوگل کاهش پیدا می کند. دو فاکتور نقش کلیدی را در مشخص کردن تقاضای Crawl در این بخش ایفا می کنند:

- محبوبیت: لینک هایی که در اینترنت محبوب تر هستند بیشتر Crawl می شوند تا به صورت تازه تری در ایندکس ما وجود داشته باشند.

- رکود: سیستم های ما تلاش می کنند تا از راکد شدن لینک ها در ایندکس جلوگیری کنند.

علاوه بر این، رویدادهای در سطح سایت ها مانند حرکات سایت ها می تواند باعث افزایش تقاضای بررسی به منظور ایندکس کردن دوباره محتوا تحت لینک های جدید شود. با در نظر گرفتن نرخ بررسی و تقاضای بررسی ما می توانیم بودجه بررسی را به تعدادی که ربات های گوگل می توانند و می خواهند بررسی کنند، تعیین کنیم.

در واقع بودجه بررسی تعداد لینک هایی است که ربات گوگل می تواند و می خواهد بررسی کند. شما باید کاری کنید که ربات گوگل بودجه بررسی خود به بهترین نحو برای سایت شما استفاده کند. به زبان دیگر، ربات باید با ارزش ترین صفحات شما را بررسی کند. فاکتورهای مشخصی هستند که طبق گفته های گوگل، تاثیر منفی روی بررسی و ایندکس کردن سایت شما می گذارند. بیایید این فاکتورها را بررسی کنیم.

فاکتورهای موثر روی بودجه بررسی و ایندکس کردن سایت

طبق بررسی های ما، داشتن لینک های بی ارزش متعدد می تواند تاثیر منفی روی بررسی و ایندکس شدن سایت داشته باشند. ما متوجه شدیم که لینک های کم ارزش در این دسته بندی ها قرار می گیرند که به ترتیب اهمیت در لیست پایین نمایش داده شده اند:

- گشت و گذار وجهی و شناسایی کنندگان Session ها

- محتوای تکراری روی سایت

- صفحات ارور دهنده

- صفحات هک شده

- فضاها و پروکسی های بی نهایت

- محتوای اسپم و بی کیفیت

هدر دادن منابع سرور روی صفحاتی مانند این ها فعالیت Crawling بر روی صفحاتی که ارزشمند هستند را کاهش می دهد، در نتیجه می توانند باعث ایجاد تاخیر قابل توجهی در پیدا کردن محتوای عالی روی سایت شما شوند.

حال بیایید به Robots.txt برگردیم. اگر صفحه Robots.txt مناسبی ایجاد کنید، می توانید به ربات های موتورهای جستجو بگویید که از یک سری صفحه مشخص دوری کنند. به پیامدهای این موضوع فکر کنید. اگر به ربات های موتورهای جستجو بگویید که تنها محتواهای کاربردی شما را چک کنند، ربات ها سایت شما را تنها بر اساس این محتواها بررسی و ایندکس می کنند.

همانطور که گوگل می گوید، شما نباید بگذارید که سرور شما پر از ربات های گوگل شود یا بودجه بررسی خود را برای بررسی صفحات مشابه یا کم اهمیت روی سایت خود هدر بدهید. با استفاده درست از فایل Robots.txt، به ربات ها می گویید که خردمندانه بودجه بررسی خود را مصرف کنند. این باعث می شود که این فایل ها در زمینه سئو مفید باشند.

پیدا کردن فایل Robots.txt

اگر می خواهید خیلی سریع نگاهی به فایل Robots.txt خود داشته باشید، راه بسیار ساده ای برای دیدن آن وجود دارد. این شیوه برای همه سایت ها جواب می دهد. بنابراین شما می توانید نگاهی به فایل های دیگر سایت ها داشته باشید و ببینید که چه کاری انجام می دهند.

تنها کاری که باید انجام دهید تایپ کردن لینک اصلی سایت مورد نظر در نوار جستجو و سپس اضافه کردن /Robots.txt به انتهای آن است. بعد از انجام این کار، سه موقعیت می تواند پیش بیاید:

- فایل Robots.txt را پیدا می کنید.

- یک فایل خالی پیدا می کنید.به عنوان مثال Disney به نظر فایل Robots.txt ندارد.

- یک ارور ۴۰۴ دریافت می کنید. مثلاً سایت Method برای Robots.txt ارور ۴۰۴ می دهد.

فایل مربوط به سایت خود را مشاهده کنید. اگر یک فایل خالی یا ارور ۴۰۴ یافتید، باید آن را درست کنید. اگر یک فایل معتبر یافتید، احتمالاً تنظیمات پیشفرضی دارد که زمان ساخت سایت تعیین شده اند. من از این شیوه بیشتر به این دلیل خوشم می آید که می توانید فایل های سایت های دیگر را نیز ببینید. زمانی که در زمینه فایل های Robots.txt خبره شدید، این می تواند یک تمرین با ارزش برایتان باشد. حال بیایید به سراغ تغییر این فایل برویم.

تغییر فایل Robots.txt

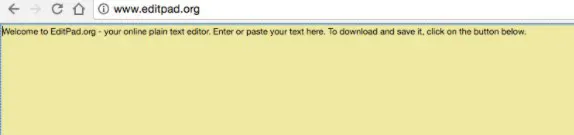

مراحل بعدی که باید انجام دهید به این بستگی دارد که فایل مورد نظر را دارید یا خیر. اگر این طور نیست، باید یک فایل جدید را از ابتدا بسازید. اول یک ویرایشگر متن ساده مانند Notepad را باز کنید. برای این کار تنها باید از ویرایشگرهای ساده استفاده کنید، اگر از برنامه هایی مانند Word استفاده کنید، برنامه ممکن است کدهای اضافی را وارد متن شما بکند.

Editpad.org نیز یک سایت برای انجام این کار به صورت رایگان است.

اگر فایل Robots.txt را داشته باشید، باید آن را در Root Directory سایت خود پیدا کنید. اگر به گشت و گذار در Source Code ها عادت ندارید، ممکن است پیدا کردن نسخه قابل ویرایش فایل Robots.txt شما کمی کار سختی باشد.

معمولاً می توانید Root Directory خود را با رفتن به اکانت وب سایت هاستینگ خود و لاگین کردن و رفتن به بخش مدیریت فایل ها یا FTP در سایت خود پیدا کنید. قاعدتاً بعد از این کار باید با صفحه ای مانند تصویر زیر مواجه شوید.

فایل Robots.txt را پیدا کرده و برای ویرایش آن را باز کنید. تمام متن موجود را پاک کنید اما فایل را نگه دارید. این کار به این علت انجام می شود که وردپرس یک فایل Robots.txt مجازی ایجاد می کند اگر هیچ فایلی با این اسم در Root Directory موجود نباشد. اگر این اتفاق برای شما بیافتد، باید یک فایل Robots.txt جدید ایجاد کنید.

ساخت فایل Robots.txt

شما می توانید این فایل را همان طور که اشاره شد با استفاده از یک ویرایشگر متن ساده مانند نوت پد ایجاد کنید. اگر این فایل را از قبل دارید، مطمئن شوید که متن آن را پاک کرده اید. ابتدا باید با یک سری از اصطلاحات استفاده شده در زمینه این فایل ها آشنا شوید.

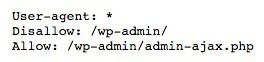

ساده ترین فایل Robots.txt از ۲ کیوورد استفاده می کند، User Agent و Disallow. User Agentها ربات های موتورهای جستجو هستند؛ بیشتر آن ها در لیست دیتابیس ربات های وب قرار دارند. Disallow یک فرمان برای User Agent است که به آن ها می گوید به یک لینک مشخص دسترسی نداشته باشد. در طرف مقابل، برای دسترسی دادن به گوگل برای یک لینک مشخص که یک Directory زیرشاخه که در یک Directory مادر Disallow شده قرار دارد، شما می توانید از کیوورد سومی تحت عنوان Allow استفاده کنید.

گوگل از چندین User Agent استفاده می کند، مانند Googlebot برای جستجو و Googlebot-image برای جستجوی عکس های گوگل. بیشتر User Agentهای گوگل از قوانینی که برای Googlebot تعیین می کنید پیروی می کنند، اما شما می توانید این آپشن را تغییر داده و قوانین مشخصی را برای دیگر User Agentهای گوگل تعیین کنید.

نحوه استفاده از اصطلاحات بخصوص این زمینه به شیوه پایین می باشد:

- User Agent: [ نام رباتی که قانون مورد نظر در مورد آن اعمال می شود]

- Disallow: [مسیر لینکی که می خواهید بلاک کنید]

- Allow: [ مسیر لینک یک دایرکتوری زیر شاخه، درون یک دایرکتوری مادر بلاک شده، که می خواهید آن را آنبلاک کنید]

این دو لاین به همراه هم به عنوان ورودی تنها در فایل محسوب می شوند، جایی که قانون Disallow تنها بر روی User Agentهای مشخص شده بالای خود اعمال می شود. شما می توانید هر چقدر ورودی که می خواهید شامل کنید و همچنین چندین خطوط Disallow می توانند بر روی چندین User Agent اعمال شوند. شما می توانید فرمان User Agent را برای اعمال شدن روی تمامی ربات های وب از طریق یک علامت ستاره (*) مانند مثال پایین لیست کنید.

User Agent: *

در این قسمت می خواهیم به شما نحوه راه اندازی یک فایل Robots.txt ساده را آموزش دهیم و سپس خواهیم دید که چطور می توانیم آن را برای سئو بهینه سازی کنید.

با تنظیم کردن User Agentها شروع کنید. ما می خواهیم آن را به نحوی تنظیم کنید که بر روی تمامی ربات های وب اعمال شود. این کار را با استفاده از یک ستاره بعد از User Agent مانند مثال پایین انجام می دهیم.

User Agent: *

سپس Disallow را تایپ کنید اما هیچ چیزی بعد از آن تایپ نکنید.

Disallow:

از آن جایی که هیچ چیز بعد از Disallow وجود ندارد، ربات های وب تمام سایت شما را بررسی خواهند کرد. در حال حاضر، همه سایت شما در دسترس آن هاست. تا الان باید فایل شما ظاهری این گونه داشته باشد:

User Agent: *

Disallow:

درست است که خیلی ساده به نظر می آید، اما همین دو خط کوتاه در حال حاضر نیز کارهای زیادی انجام می دهند. شما همچنین می توانید به نقشه سایت XML خود لینک بزنید، اما این کار ضروری نیست. اگر می خواهید این کار را انجام دهید، چنین چیزی را باید تایپ کنید:

Sitemap: https://yoursite.com/sitemap.xml

باور کنید یا نکنید، یک فایل ساده Robots.txt این چنین است. حال بایید به مرحله بعد برویم و ببینیم که چطور می توان از این فایل برای بهبود سئو استفاده کرد.

بهینه سازی Robots.txt برای سئو

نحوه بهینه سازی این فایل توسط شما کاملاً به محتوایی که روی سایت خود دارید بستگی دارد. راه های مختلفی برای استفاده از این فایل به نفع خود وجود دارد. در این قسمت به چند شیوه رایج تر برای استفاده از آن ها می پردازیم. در نظر داشته باشید که شما نباید از Robots.txt برای بلاک کردن صفحات از موتورهای جستجو به هیچ وجه استفاده کنید!

یکی از بهترین شیوه های استفاده از این فایل بیشینه سازی بودجه بررسی موتورهای جستجو با گفتن این که بخش هایی از سایت شما که به نمایش عموم درنمی آید را بررسی نکنند، است. به عنوان مثال، اگر فایل Robots.txt سایت neilpatel.com را نگاه کنید، می بینید که صفحه لاگین را Disallow کرده است. از آن جایی که از این صفحه برای لاگین کردن به بخش پایه سایت استفاده می شود، منطقی نیست که موتورهای جستجو زمان خود را برای بررسی این صفحه هدر دهند.

شما می توانید از یک بخشنامه (یا فرمان) مشابه برای جلوگیری از بررسی صفحات بخصوص توسط ربات ها جلوگیری کنید. بعد از Disallow، بخشی از لینک که بعد از .com می آید را وارد کنید، این بخش را باید میان دو اسلش قرار دهید.

بنابراین اگر می خواهید به یک ربات بگویید که صفحه ای از سایت شما با لینک فرضی http://yoursite.com/page/ را بررسی نکند، باید این را تایپ کنید:

شاید برای شما سوال شده باشد که دقیقاً کدام صفحات را باید برای ایندکس شدن در نظر نگیرید. در این بخش چند سناریو را می بینید که ممکن است این اتفاق بیافتد:

محتوای تکراری هدفمند: در حالی که محتوای تکراری عموماً چیز بدی است، چند مورد انگشت شمار وجود دارند که در آن ها محتوای تکراری می تواند ضروری و قابل قبول باشد. به عنوان مثال، اگر یک نسخه مناسب پرینتر از یک صفحه دارید، در واقع محتوای تکراری دارید. در این مورد، می توانید به ربات ها بگویید که یکی از این نسخه ها را بررسی نکنند. این کار همچنین وقتی می خواهید صفحاتی را که محتوای مشابه با طراحی متفاوت دارند را تست های جداگانه بگیرید، کاربردی است.

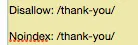

صفحات تشکر: صفحه تشکر یکی از صفحات مورد علاقه بازاریابان است چرا که به معنی یک سرنخ جدید می باشد. درست است؟ این طور که معلوم است، بعضی از صفحات تشکر از طریق گوگل قابل دسترسی هستند. بدین معنی که مردم می توانند به این صفحات دسترسی داشته باشند بدون این که لازم باشد وارد پروسه گرفتن سرنخ نشوند و این اتفاق خوبی نیست.

با بلاک کردن صفحات تشکر، اطمینان حاصل می کنید که تنها سرنخ های تایید شده می توانند آن ها را ببینند. فرض کنید که صفحه تشکر دارای لینک https://siteshoma.com/thank-you/ است. در فایل Robots.txt خود این صفحه باید ظاهر این چنینی داشته باشد.

Disallow: /thank-you/

از آن جایی که هیچ قانون جهانی برای این که کدام صفحات Disallow شوند وجود ندارد، فایل Robots.txt شما برای سایت شما منحصر به فرد خواهد بود. دو بخشنامه دیگر وجود دارد که باید از آن ها اطلاع داشته باشید، noindex و nofollow.

Disallow هایی که تابحال از آن ها استفاده کردیم جلوی ایندکس شدن صفحه را نمی گیرند. بنابراین به صورت تئوری، می توانید یک صفحه را Disallow کنید، اما باز هم سر از ایندکس در می آورد. عموماً این چیز خوبی برای شما نیست.

به همین دلیل است که فرمان یا بخشنامه noindex وجود دارد. این فرمان با فرمان Disallow کار می کند تا مطمئن شود که ربات صفحات بخصوصی از سایت شما را نه بازدید کرده و نه ایندکس می کند. اگر صفحه ای دارید که نمی خواهید ایندکس شود می توانید از هر دو فرمان Disallow و noindex استفاده کنید.

حالا این صفحه در صفحه نتایج جستجوی گوگل به نمایش در نخواهد آمد.

در نهایت، به فرمان nofollow می رسیم. این فرمان در واقع همان nofollow Link است. به صورت خلاصه، این فرمان به ربات وب می گوید که لینک های روی صفحه را بررسی نکند، اما فرمان Nofollow کمی متفاوت تر از فرمان های دیگر پیاده سازی می شود چرا که در واقع بخشی از فایل Robots.txt نیست.

اگرچه فرمان Nofollow همچنان به ربات های وب دستور می دهد، بنابراین الگو همان است، تنها تفاوت در مکانی است که اتفاق می افتد. ابتدا باید Source Code صفحه ای که می خواهید تغییر دهید را پیدا کنید و مطمئن شوید که میان تگ های <head> است. سپس این خط را در آن جا قرار دهید:

<meta name=”robots” content=”nofollow”>

بنابراین باید ظاهری مانند این داشته باشد:

<head>

<meta name=”robots” content=”nofollow”>

<head>

مطمئن شوید که این خط را میان هیچ تگ دیگری قرار ندهید، فقط تگ های <head>.

این یک آپشن خوب دیگر برای صفحات تشکر است چرا که ربات های وب لینک های منجر شونده به هیچ آهنربای سرنخی یا دیگر محتواهای اختصاصی را بررسی نخواهند کرد. اگر می خواهید هر دو فرمان noindex و nofollow را داشته باشید، از این خط کد استفاده کنید:

<meta name=”robots” content=”nofollow,noindex”>

این به ربات ها هر دو فرمان را به صورت همزمان خواهد داد.

در نهایت شما باید فایل Robots.txt خود را تست کنید تا مطمئن شوید همه چیز معتبر است و به خوبی در جهت درست در حال عمل کردن می باشد. گوگل یک تست کننده رایگان فایل Robots.txt را به عنوان بخشی از ابزار وبمستر ارائه می دهد. ابتدا باید به اکانت وبمستر خود وارد شوید با کلیک کردن بر روی Sign in در بالا سمت راست تصویر، سپس وب سایت خود را انتخاب کرده و از نوار سمت چپ Crawl را انتخاب کنید.

اینجا می توانید تست کننده Robots.txt را ببینید، روی آن کلیک کنید. اگر از قبل کُدی در باکس وجود دارد، آن را پاک کنید و با فایل جدید خود جایگزین کنید. تست را از قسمت پایین سمت راست انتخاب کنید. اگر تست به Allowed تغییر پیدا کرد، بدین معنی است که فایل شما معتبر است.

به اشتراک گذاری ترفندهای کمتر شناخته شده سئو که می توانند برتری زیادی به شیوه های مختلف به شما نسبت به دیگران بدهند همیشه لذت بخش است. با راه اندازی فایل Robots.txt خود به صورت مناسب، نه تنها می توانید سئوی خود را بهبود بخشید بلکه به بازدیدکنندگان خود نیز کمک می کنید. اگر ربات های موتورهای جستجو به درستی بودجه بررسی خود را صرف کنند، آن ها محتوای شما را به بهترین شیوه در صفحه نتایج جستجو سازماندهی می کنند و نمایش می دهند، بدین معنی که شما در معرض دید افراد بیشتری قرار خواهید گرفت.

جمع بندی

راه اندازی یک فایل Robots.txt نیز زحمت زیادی ندارد. این کار معمولاً یک کار یکباره است و می توانید بعداً تغییرات کوچک در صورت نیاز را اعمال کنید. فرقی نمی کند که می خواهید اولین یا پنجمین سایت خود را راه اندازی کنید، استفاده از فایل Robots.txt می تواند تفاوت قابل توجهی ایجاد کند بنابراین به شما پیشنهاد می کنیم که اگر تابحال به آن نپرداخته اید، الان بهترین زمان ممکن است.